구글이 5일(현지시각) 최신 인공지능(AI) 생성기를 개발했다고 밝혔다.

인공지능(AI) 모델에 접속해 텍스트(프롬프트)로 만들고 싶은 동영상을 묘사하면 약 5초짜리 고선명 (HD) 동영상을 만들어주는 AI다. 이른바 텍스트-투-비디오(text-to-video)다. 고선명(HD 1280x768·24fps)급 동영상을 만든다. 지난달말 메타(이전 페이스북)가 메이크어 비디오(Make-a-Video)를 만들어 발표한 지 5일만이다.

하지만 이렇게 간단하게 동영상을 만들어주는 AI시대가 다가오고 있음에도 몇가지 해결과제는 여전하다. 이들 업체가 앞서 나온 그림을 만들어주는 AI, 이른바 ‘텍스트투이미지(text-to-image)’ AI모델과 달리 ‘텍스트투비디오’ 출시에 대해서는 조심스런 입장이다. 구글의 이매젠 비디오 개발을 계기로 ▲텍스트투이미지에서 진일보해 막 쏟아지는 텍스트투비디오 AI의 기능과 특징 ▲이의 실현을 위한 핵심기술인 ‘디퓨전 모델’ ▲그리고 이의 보편적 사용에 이르기 위한 해결 과제에 대해 알아봤다.

가열되는 텍스트투비디오 AI 경쟁···어떤 기능과 기술이 사용됐나?

오픈AI가 지난 4월 텍스트를 써넣으면 스틸 예술 작품을 만들어주는 AI 생성기인 달리(DALL-E2) 출시 후 6개월 만에 이미지 생성기, AI 확산 모델 분야의 기술 발전이 급진전되면서 경쟁 급가열 양상을 보이고 있다.

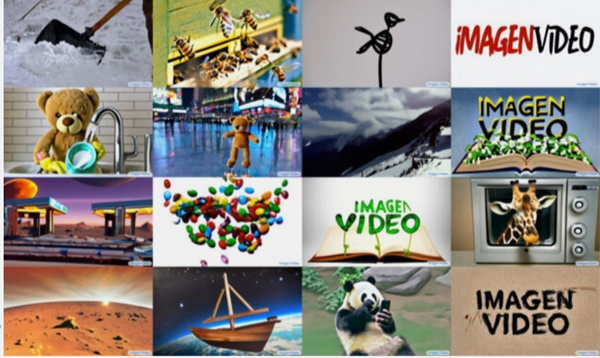

구글이 5일(현지시각) 프롬프트(글로 묘사한 제작 지시서)에서 초당 24프레임(24fps)으로 1280×768개의 동영상을 제작할 수 있는 텍스트 투 비디오 AI인 ‘이매젠 비디오(Imagen Video)’를 개발했다고 발표했다.

구글의 연구 논문에 따르면 이매젠 비디오는 ▲유명한 화가의 작품(예를 들어 빈센트 반 고흐의 그림)의 , Vincent van Gogh의 그림)을 기반으로 한 비디오 생성 ▲객체 구조를 보존하면서 3D 회전 객체 생성 ▲입력된 텍스트를 다양한 애니메이션 스타일로 렌더링하는 것 등 몇 가지 주목할 만한 양식상의 능력을 포함하고 있다.

구글은 범용 비디오 합성 모델이 “고품질 콘텐츠 생성의 어려움을 크게 줄일 수 있다”며 기대감을 높였다.

이매젠 비디오 능력의 핵심은 초기 텍스트 프롬프트(예를 들어 ‘접시를 닦는 곰’)를 저해상도 비디오(16프레임, 24×48픽셀, 3fps)로 변환한 다음, 각 단계마다 점진적으로 더 높은 프레임율을 가진 더 높은 해상도로 스케일업 하는 7가지 확산모델(디퓨전 모델)이다. 이를 계단을 오르는 것처럼 단계적으로 성능을 향상시켜 최종 작품을 만드는 방식이다. 최종 출력되는 비디오의 길이는 5.3초에 이른다.

구글 이매젠 비디오 웹사이트에서 제공되는 비디오 사례는 일상적인 것(‘콘에서 떨어지는 녹는 아이스크림’)에서부터 더 환상적인 것(‘폭풍치는 바다 위에서 해적선 간의 치열한 전투를 뚫곻 날아가는 것’)에 이르기까지 다양하다.

그것들은 명백하게 인공물들을 포함하고 있지만 5개월 전 첫 선을 보인 코그 비디오(CogVideo) 같은 이전의 텍스트-투-이미지(스틸) 모델들보다 더 유연성과 디테일을 보여준다.

구글이 이매젠 개발 소식을 전한 이날 또 다른 텍스트-투-비디오 AI 모델 ‘페나키(Phenaki)’도 공식 데뷔를 했다. 페나키 모델은 상세한 프롬프트를 이용해 더 긴 비디오를 만들 수 있다는 게 자랑이다.

이는 텍스트 프롬프트에서 3D 모델을 만들 수 있는 드림퓨전(DreamFusion)과 함께 아카이브(arXiv)의 AI 논문 수가 기하급수적으로 증가하면서 일부 연구자들이 최신 개발상황을 따라가기 어려울 정도로 디퓨전 모델에 대한 경쟁이 빠르게 지속되고 있다는 것을 보여준다.

컴퓨터비전 AI에 사용되는 ‘디퓨전 모델’ 진화 거듭

화제의 텍스트투비디오는 비전 AI에 사용되는 이른바 ‘디퓨전 모델(Diffusion model)’의 진일보를 말해 준다. 프롬프트만 써넣으면 그림과 동영상을 만들어 내 주는 디퓨전 모델은 AI가 백지 상태에서 그림을 그리기 때문에 매우 다양한 그림을 그릴 수 있다는 평가를 받고 있다.

디퓨전 모델이란 뭘까.

앞서 달리로 대표되는 ‘문장을 그림으로 전환(텍스트투이미지)’해주는 AI가 탄생한 것도 ‘디퓨전 모델’이라는 새로운 AI훈련 영역이 개척됐기에 가능해졌다.

‘디퓨전 모델’은 AI에게 이미지를 연속적으로 학습시킨 뒤 백지상태서 그려내는 방식이다. 이는 기존의 비전 기계학습 방식에서 한단계 더 나아간 것이다.

기존의 컴퓨터 비전인식 등에 주로 쓰인 모델은 적대적 생성신경망(Generative Adversarial Networks·GAN)이라는 기계학습 방식에 기반한 것이었다.

이는 두 개의 AI신경망, 즉 이미지를 생성하는 ‘생성자(generator)’와 해당 이미지가 진짜인지 가짜인지 판별하는 ‘판별자(discriminator)’를 만들어 이들을 서로 경쟁시켜 이미지를 생성하면 이에 따른 진위 판단과 감별을 반복하면서 정확도를 높여가게 만든 구조다. 생성자가 그린 그림이 가짜로 판별이 나면 생성자는 또 다른 그림을 그려 판별자가 인식할 수 없을 정도로 반복해서 더 진짜 같은 그림을 그리도록 설계한 것이다.

텍스트투이미지 AI의 대명사 격인 달리2도 디퓨전 모델을 사용했지만 구글의 이매젠은 이보다 진일보했다는 평가다.

메타·구글 개발 급가속···상용화는 신중 모드

구글의 ‘이매젠 비디오’는 현재 연구 단계지만 이매젠 비디오 합성 모델의 급속한 개발을 지적한 지 5개월 만에 모습을 드러낼 정도로 전력 질주해 온 것이다.

그래서 구글의 ‘이매젠 비디오’ 발표는 메타가 텍스트-투-비디오 AI 도구인 메이크어비디오(Make-a-Video)를 공개한 지 일주일도 안 돼 나왔다.

하지만 메타나 구글은 이처럼 전력질주해 개발한 텍스트투비디오 AI는 텍스트투이미지와 달리 본격 상용화에 나서기엔 걸림돌이 있다.

구글에 따르면 구글 이매젠 비디오 훈련 데이터는 공개적으로 사용할 수 있는 ‘LAION-400M’ 이미지 텍스트 데이터 세트와 ‘1400만개의 비디오-텍스트 쌍 및 6000만개의 이미지-텍스트 쌍’을 사용했다.

그 결과 ‘이매젠 비디오’는 구글이 필터링한 ‘문제있는 데이터’에 대한 교육을 받았지만, 여전히 성에 대해 노골적이고 폭력적인 콘텐츠와 사회적 고정관념 및 문화적 편견을 포함할 수 있다. 구글은 또 자사의 도구가 “가짜, 증오, 명시적, 또는 유해한 콘텐츠를 생성하는 데” 사용될 수 있다고 우려한다.

결과적으로 구글이 이를 조만간 공개할 가능성은 낮아 보인다.

구글은 “이러한 우려가 완화될 때까지 이매젠 비디오 모델이나 소스 코드를 공개하지 않기로 결정했다”고 밝혔기 때문이다.

저작권 침해 문제 우려도 있다.

최근 번역과 대화, 작문을 할 수 있는 인공지능인 ‘GPT-3’의 보안 결함을 밝혀낸 영국의 컴퓨터 과학자 사이먼 윌리슨은 메타가 텍스트 투 비디오 AI인 메이크어비디오를훈련시키기 위해 사용한 비디오 데이터 분석 결과, 심각한 저작권 침해 우려를 제기했다.

그는 메타의 메이크어 비디오가 저작권 있는 이미지 영상 판매사이트인 게티이미지나 셔터스톡에 등재된 1000만개 이상의 영상을 무단 사용한 것으로 나타났다고 밝혔다. (지난 6월 메타는 텍스트 설명과 함께 장면 레이아웃을 설명하는 매우 대략적인 스케치에서 (스틸)이미지를 생성할 수 있는 멀티모달 AI 시스템인 ‘메이크어신(Make-a-Scene)’을 선보였다. 메이크어비디오는 이 시스템의 추가 개발결과다. 텍스트-이미지 쌍 외에도 메타는 라벨링 되지 않은 비디오 데이터로 이를 위한 AI를 훈련시켰다. 메타에 따르면 이 회사는 라벨링된 비디오 데이터를 제거함으로써 교육 비용을 줄였다. 메타는 공개 데모를 발표했지만 일정을 밝히지 않았다. 현재 모델은 가능한 릴리스의 모든 단계가 안전한지 확인하기 위해 내부에서 분석되고 테스트될 예정이다.)

왁시의 앤디 베이오는 마이크로소프트 리서치 아시아(Microsoft Research Asia)가 편집한 데이터 세트에서는 유튜브 비디오 330만 개에서 따온 약 1천만 개의 클립이 나왔다고 밝혔다. 이러한 데이터 세트는 나중에 상업적으로 사용될 AI 모델을 훈련하기 위해 기업들의 연구에 도 사용될 것이다.

두 저자는 메타가 해당 동영상을 AI 훈련에 사용하는 데 동영상 제작자의 동의가 없었다고 추정한다.

소셜댓글