[AI요약] 엔비디아가 80% 이상 차지하고 있는 AI칩 시장에서 AMD가 강력한 도전장을 내밀었다. AMD는 AI를 위한 가장 진보된 GPU인 MI300X를 공개했으며, 이는 엔비디아 칩을 대신할 제품으로 가능성이 큰 것으로 평가받고 있다. 세계 최대의 클라우드 컴퓨팅 공급자인 아마존웹서비스는 AMD의 새로운 AI 칩 사용을 고려중이다.

어드밴스드 마이크로 디바이시스(AMD)가 새롭게 공개한 새로운 인공지능(AI) 칩에 대해 로이터통신, CNBC 등 외신이 14일(현지시간) 보도했다.

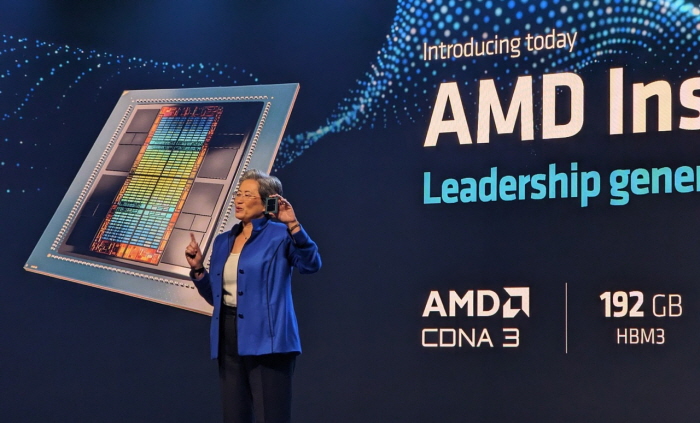

AMD는 AI를 위한 가장 진보된 GPU인 MI300X를 올해 말 일부 고객에게 배송하기 시작할 것이라고 발표했다. 이번 AMD의 발표는 현재 엔비디아가 80% 이상 차지하고 있는 AI칩 시장에 대한 강력한 도전이 될것으로 보인다.

GPU는 오픈AI(OpenAI)와 같은 기업이 만든 챗GPT(ChatGPT) 등 최첨단 AI 프로그램을 구축하는 데 사용되는 칩이다.

‘가속기’라고도 불리는 AMD의 AI 칩을 개발자와 서버 제조업체에서 엔비디아 제품을 대신할 제품으로 채택할 경우, 기존 컴퓨터 프로세서로 가장 잘 알려진 칩 제조업체인 엔비디아에 큰 타격이 될수 있다.

데이터센터 AI 가속기 시장은 올해 300억달러(약 38조2500억원)에서 연평균 50% 이상의 성장률로 2027년에는 1500억달러(약 191조2500억원) 이상으로 성장할 것으로 관측되고 있다.

AMD는 가격을 공개하지는 않았지만 H100과 같은 엔비디아의 GPU에 가격 압박을 가할 가능성이 크다. GPU 가격을 낮추면 생성 AI 애플리케이션을 제공하는 데 드는 높은 비용을 낮추는 데도 도움이 될수 있다.

AMD의 새로운 MI300X 칩과 CDNA 아키텍처는 대형언어모델 등 기타 최첨단 AI 모델용으로 설계됐다. MI300X는 최대 192GB의 메모리를 사용할 수 있어 다른 칩보다 더 큰 AI 모델에 맞출 수 있다. 예를 들어 엔비디아의 H100은 120GB의 메모리만 지원하고 있다.

생성 AI 애플리케이션을 위한 대규모 언어 모델은 점점 더 많은 계산을 실행하기 때문에 더 큰 메모리를 사용한다. AMD는 샌프란시스코에서 열린 투자자와 분석가를 대상으로한 프리젠테이션을 통해 팔콘(Falcon)이라는 400억 매개변수 모델을 실행하는 MI300x를 시연했다. 오픈AI의 GPT-3 모델에는 1750억개의 매개변수가 있다.

현재 언어 모델 크기는 훨씬 더 커지고 있으며 최신 대형 언어 모델을 실행하려면 실제로 여러 개의 GPU가 필요한 상황이다.

또한 AMD는 M1300X 가속기 8개를 하나의 시스템에 결합한 인피니티 아키텍처를 제공할 예정이다. 엔비디아와 구글은 AI 애플리케이션을 위해 단일 상자에 8개 이상의 GPU를 결합하는 유사한 시스템을 개발했다.

그동안 AI 개발자들이 엔비디아 칩을 선호했던 이유는 칩의 핵심 하드웨어 기능에 액세스할 수 있도록 하는 CUDA라는, 잘 개발된 소프트웨어 패키지가 있기 때문이다. 이에 AMD는 이번 최신 칩 공개를 통해 기업이 ‘ROCm’이라는 AI 칩용 자체 소프트웨어를 가지고 있다고 밝혔다.

이러한 가운데 세계 최대의 클라우드 컴퓨팅 공급자인 아마존웹서비스(Amazon Web Services, AWS)가 AMD의 새로운 AI 칩 사용을 고려하고 있는 것으로 알려졌다.

AWS는 클라우드 서비스에서 AMD의 새로운 MI300 칩을 사용하겠다고 공개적으로 밝히지는 않았지만, 데이브 브라운 아마존 컴퓨팅 클라우드 부사장은 기업이 이를 고려하고 있다고 언론을 통해 밝힌 상태다.

브라운 부사장은 “"AWS와 AMD은 여전히 함께 작업하고 있다”며 “기존 시스템에 연결하는 설계와 관련해 AMD의 기술을 통해 큰 이점을 얻었다”고 밝혔다.

리사 수 AMD CEO는 “AI는 기업의 가장 크고 전략적인 장기 성장 기회”라고 “이 중심에는 GPU가 있으며, 이는 생성 AI를 가능하게 한다”고 설명했다.

소셜댓글