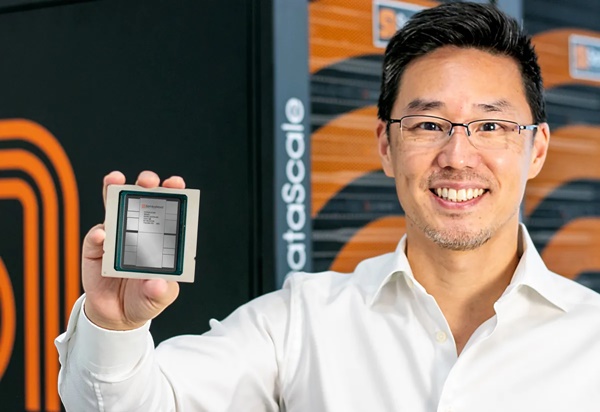

“삼바노바 스위트에 힘을 제공하고 있는 최신 AI칩 ‘SN40L’을 만나보시라.”

지난달 19일 팰러앨토의 한 스타트업이 트위터(X)를 통해 새로운 괴물 인공지능(AI) 칩을 공개하면서 이와 함께 제공되는 풀스택 AI 플랫폼 가동과 서비스를 알렸다.

삼바노바는 자사의 AI 모델용 칩인 SN40L이 “혁신적 디자인을 갖춘 업계 최초의 혁신적 제품이다···단일 시스템 노드에서 256k+ 시퀀스길이를 가진 5조 개(GPT-4의 약 3배)의 파라미터(매개변수) 모델을 제공한다. 이는 통합 스택에서만 가능하며···더 낮은 총 소유 비용(TCO)으로 더 높은 품질의 모델과 더 빠른 추론 및 훈련을 할 수 있다”고 소개했다. 또 “고객들은 GPT-4와 같은 1조 개의 매개변수 모델의 힘을 갖춘 LLM(거대언어모델)을 요구하고 있지만, 그들은 또한 자신의 데이터 상에서 정교하게 조정된 모델을 소유하는 것의 이점을 원하고 있기도 하다. 현재까지 가장 진보된 우리의 AI 칩(SN40L)을 풀스택 LLM 플랫폼에 통합함으로써, 모델 정확도를 희생시키지 않고 고객들에게 훈련과 추론을 위해 더 높은 성능을 가진 가장 큰 LLM을 실행할 수 있는 열쇠를 제공하고 있다”고 말했다.

이 회사는 SN40L 칩 활용상 이점을 요약하자면 ▲오픈AI GPT-4의 3배에 달하는 매개변수를 가진 모델을 제공하는 점 ▲단일 시스템 노드에서 25만6000개 이상의 입력데이터 시퀀스 길이가 가능하다는 점 ▲기존 모델을 소유하는 것의 이점을 제공한다는 점(멀티모드에서 손쉬운 데이터 검색, 분석 및 생성 지원), 그리고 ▲LLM 추론 실행시 더큰 효율성으로 AI 모델 총소유비용(TCO)을 낮춘다는 점 등이다.

전세계 2000대 기업을 타깃고객으로 삼고 있다는 이 스타트업의 성과와 도전, 그리고 업계를 지배하는 엔비디아의 경합하는 다크호스의 패권 경쟁 가능성에 대해 알아봤다. 삼바노바 발표내용, 스펙트럼엔지니어링, 인터레스팅 엔지니어링 보도를 참고했다.

엔비디아에 대적할 다크호스 AI 칩 등장

삼바노바는 지난달 19일 트위터(X)에 자신들이 개발한 SN40L GPU칩을 올려 이 AI칩 개발사실을 공식화했다.

미국 팰러앨토 기반 인공지능(AI) 칩 스타트업인 삼바노바(SambaNova)는 자사가 개발해 공급하는 SN40L 칩을 AI모델 구동 칩 경쟁의 선두주자이자 최근 시장에서 가장 강력한 칩인 엔비디아 GH200의 대안으로 소개하고 있다.

대만 TSMC의 5나노미터 공정을 사용해 제작된 SN40L의 각 장치는 최대 638테라플롭스(1테라플롭=초당 1조개 부동소수점연산)의 속도를 낼 수 있는 1040개의 코어의 1020억 개 트랜지스터를 특징으로 한다. 이는 또한 AI 워크로드와 관련된 거대한 데이터 흐름에 대처하기 위해 설계된 새로운 3단 메모리 시스템을 가지고 있다.

SN40L칩은 480GB의 CPU 램과 96GB의 GPU 램을 지원한다. (지난 8월 시그래프에서 발표된 엔비디아 GH200 업데이트 버전은 H100과 동일한 GPU에 141GB의 최첨단 메모리 및 72코어 암 기반 CPU를 결합했다.)

메모리는 점점 더 AI 칩의 주요 차별화 요소가 되고 있다. 이는 점점더 커지는 생성 AI 모델의 크기로 인해 데이터 이동시 원래 컴퓨팅 성능에 비해 성능장애를 보이는 생기는 경우가 많아지기 때문이다. 이는 AI칩 기업들에게 메모리 양과 속도를 모두 향상시키도록 압박하고 있다.

SN40L 메모리의 특징은 제 3 메모리 계층을 추가했다는 점이다. 520MB의 온칩 메모리와 1.5테라바이트의 외부 메모리, 64기가바이트의 HBM(고대역메모리)를 추가 탑재한다. 물론 삼바노바의 HBM 적용이 처음은 아니며 새로운 칩(SN40L)은 경쟁사보다 작은 메모리를 특징으로 한다.

엔비디아의 H100 GPU는 80GB 값을 특징으로 하는 반면 곧 출시될 AMD의MI300X GPU는 192GB를 특징으로 한다. (엔비디아가 내년 2분기 양산을 시작하겠다고 밝힌 차세대 AI 칩 GH200에는 전작인 'H100 대비 HBM 탑재량이 2배 가까이 늘어날 것으로 예상된다. 기존 H100 제품에는 80GB HBM3가 사용되지만 GH200에는 144GB HBM3E가 탑재된다.)

아쉽게도 삼바노바는 메모리의 대역폭 수치를 공개하지 않을 것이기 때문에 다른 칩과 어떻게 비교되는지 판단하기가 어렵다는 지적이 나온다.

량 삼바노바 CEO는 자사가 개발한 기술은 느린 외장 메모리에 더 의존하지만, 세 개의 메모리 층 사이의 부하를 지능적으로 분할할 수 있는 소프트웨어 컴파일러를 선택했다고 밝히고 있다. 또한 이 회사는 자사 고유의 칩 간 상호 연결을 통해 컴파일러가 8개의 프로세서 구성을 하나의 시스템인 것처럼 처리할 수 있도록 했다고 설명했다.

패터 러튼 IDC 성능 집약적 컴퓨팅 연구 담당 부사장은 “삼바노바의 SN40L 칩은 독특하다. 이 칩은 하나의 칩에서 고대역메모리(HBM)와 D램을 모두 처리해 AI 알고리즘이 당면한 작업에 가장 적합한 메모리를 선택할 수 있도록 한다. 이는 그러지 않을 경우 달성할 수 있는 것보다 훨씬 더 많은 양의 메모리에 직접 접근할 수 있게 해준다. 또한 이 칩들은 삼바노바의 RDU(Reconfigurable Data Unit) 아키텍처를 사용함으로써 더 스마트한 컴퓨팅을 사용해 희소 모델을 효율적으로 실행할 수 있도록 설계됐다”고 설명했다.

매개변수 5조개 될 때까지 처리하는 ‘게임 체인저’

삼바노바의 이론은 기존 칩 설계가 명령어 흐름을 완화하는 데 지나치게 집중돼 있지만 대부분의 머신러닝 애플리케이션의 경우 데이터의 효율적인 이동이 더 큰 병목 현상을 겪고 있다는 것이다.

이를 해결하기 위해 삼바노바는 자사 칩에 고속 스위칭 패브릭으로 연결된 타일 어레이의 메모리 및 컴퓨팅 장치를 두어 당면한 문제에 따라 장치가 연결되는 방식을 동적으로 재구성할 수 있도록 했다. 이는 기계 학습 모델을 분석하고 장치를 연결하는 최상의 방법을 찾아내 원활한 데이터 흐름과 최대 하드웨어 사용을 보장할 수 있는 삼바플로우 소프트웨어와 함께 작동한다.

삼바노바는 자사의 이 SW군과 AI칩의 결합은 ‘게임 체인저’가 될 것이라며 기대감을 감추지 않고 있다.

올로코툰 삼바노바 공동창업자는 “고객들은 GPT-4와 같은 조 단위의 매개변수 모델의 힘을 갖춘 LLM을 요구하고 있지만, 또한 데이터를 미세 조정된 모델을 소유하는 이점을 원하고 있다. 우리는 현재까지 가장 진보된 AI 칩인 새로운 SN40L을 풀스택 LLM 플랫폼에 통합함으로써 모델 정확도를 희생하지 않고 고객들에게 훈련 및 추론을 위한 더 높은 성능의 가장 큰 LLM을 실행할 수 있는 열쇠를 제공하고 있다”고 설명했다.

삼바노바는 자사의 칩이 오픈 AI의 GPT-4 LLM 크기의 거의 3배에 달하는 5조 개의 매개 변수를 가진 모델을 지원할 수 있다고 주장한다. 이는 모델이 처리할 수 있는 입력 길이의 척도인 시퀀스 길이가 25만6000개의 토큰에 해당한다는 것이다.

로드리고 량 삼바노바 CEO는 산업 표준 GPU를 사용해 동일한 작업을 수행하려면 수백 개의 칩이 필요하며, 이는 산업 표준 접근 방식의 총 소유 비용의 1/25에도 미치지 못한다고 말한다.

10억 달러 이상의 벤처 자금을 조달한 삼바노바는 기업에 직접 칩(만)을 판매하지는 않는다. 대신 가장 큰 AI 모델을 구동하도록 특별히 설계된 고유의 하드웨어(HW)와 소프트웨어(SW)를 특징으로 하는 맞춤형 기술 스택에 대한 액세스를 판매한다.

풀스택으로 공급되는 삼바노바 AI칩과 스위트···고객이 모델 소유권 영구 유지

SN40L 칩은 삼바노바 스위트(SW군)를 가동하게 된다.

삼바노바 칩과 함께 제공되는 스위트(SambaNova Suite)는 칩에서 모델에 이르는 최초의 풀 스택 생성형 AI 플랫폼으로 기업 및 정부 조직에 최적화돼 있다.

이는 기업내에서 또는 클라우드에서 제공되는 완전 통합 플랫폼으로서 최첨단 오픈 소스 모델과 결합하며, 고객 데이터를 사용해 쉽고 안전하게 미세 조정해 정확도를 높일 수 있다. 고객 데이터에 적응하면 고객은 모델 소유권을 영구적으로 유지하므로 생성형 AI를 가장 가치 있는 자산 중 하나로 바꿀 수 있다.

삼바노바 팀은 6년간의 엔지니어링 및 고객 피드백을 바탕으로 AI 구현시 대한 고객들의 과제(훈련 및 추론 비용, 시퀀스 길이 제한, LLM의 속도 또는 지연 시간 등)를 깊이 생각하고 LLM 플랫폼을 완전히 모듈화하고 확장 가능하도록 설계했다고 밝혔다.

이를 통해 고객들은 추론 성능을 저하시키지 않으면서도 새로운 영역에 대한 양식과 전문 지식을 점진적으로 추가하고 모델의 패러미터(매개 변수) 수를 최대 5조개가 될 때까지 늘려 갈 수 있다.

삼바노바 스위트내에 있는 새로운 모델과 능력은 다음과 같다.

▲라마2 변형 모델들(7B, 70B)=최첨단 오픈 소스 언어 모델들은 고객들이 이 모델들에 대한 소유권을 유지하면서 사용 가능한 최고의 LLM 모델을 적용, 확장 및 실행할 수 있게 해준다.

▲블룸 176B=오픈 소스 커뮤니티에서 가장 정확한 다국어 기반 모델로, 고객들이 다양한 언어로 더 많은 문제를 해결할 수 있도록 하는 동시에 새로운 낮은 리소스 언어들을 지원하도록 모델을 확장할 수 있다.

▲고객들이 벡터 임베딩에 문서를 임베딩할 수 있어 질의응답 과정에서 검색할 수 있고 환각이 발생하지 않는 벡터 기반 검색 증강 생성을 위한 새로운 임베딩 모델이다. 이어 LLM이 그 결과를 분석, 추출하거나 정보를 요약한다.

▲음성 데이터의 전사 및 분석을 위한 세계 최고 수준의 자동화된 음성 인식 모델이다.

▲멀티 모달 및 롱 시퀀스 길이 기능이 추가됐다.

▲3단 데이터 플로우 메모리를 갖는 추론에 최적화된 시스템을 제공해 고대역폭과 고용량 성능을 저하시키지 않는다.

엔비디아 넘을까···전문가들이 말하는 삼바노바의 도전과 가능성

현재 시장에는 AI칩이 부족하고 기업들이 대규모 AI 애플리케이션과 모델을 실행하고 훈련하는 데 도움을 줄 엔비디아의 인기칩 A100, H100를 손에 넣으려면 길게는 내년말까지 기대려야 한다.

쿤레 올루코툰 삼바노바 공동창업자는 엔비디아와 달리 칩만으로는 판매하지 않고 삼바노바 스위트를 갖춘 맞춤형 기술 스택의 일부로서만 칩을 판매한다.

이에 대한 전문가들의 반응은 엇갈린다.

가트너의 분석가인 치라크 데케이트는 SN40L이 경쟁 HW에 비해 상당한 우위를 점할 가능성이 있는 한 분야로 멀티모달 AI를 꼽고 있다. 그는 생성 AI의 미래는 이미지, 비디오 및 텍스트와 같은 다양한 유형의 데이터를 처리할 수 있는 대형 모델이지만, 이로 인해 워크로드가 크게 변동한다고 말한다.

데케이트는 GPU에서 볼 수 있는 상당히 엄격한 아키텍처는 이러한 작업에 적합하지는 않지만, 삼바노바가 재설정할 수 있도록 초점을 맞춘 것이 빛을 발하는 부분이 바로 여기라고 말한다. 그는 “삼바노바는 "워크로드 요구 사항에 맞게 HW를 조정할 수 있다”고 말한다. 또 삼바노바가 만든 것과 같은 맞춤형 AI 칩은 성능과 유연성 사이에서 균형을 유지한다고 말한다. 비록 GPU 칩들은 그렇게 강력하지는 않을 수 있지만 즉시 거의 모든 신경망을 실행할 수 있으며 강력한 SW 생태계에 의해 지원된다.

데케이트는 삼바노바가 고객들이 활용할 수 있는 미리 구워진 모델들의 카탈로그를 구축하고 있지만, 시장을 지배하는 엔비디아가 AI 개발의 모든 측면에서 가지고 있는 우위는 극복해야 할 주요한 과제라고 언급한다. 그는 “(삼바노바 칩의)아키텍처는 사실 기존 GPU 아키텍처보다 우수하다. 그러나 이러한 기술을 고객의 손에 넣고 대규모로 소비자들이 사용할 수 있도록 하지 않는 한 어려움을 겪을 가능성이 높다고 생각한다”고 지적했다.

삼바노바는 대규모 기업들이 거대한 기데이터 저장소에 앉아 있지만 대부분의 데이터가 무엇을 말하는지 모른다는 데에 영업의 초점을 맞추고 있다. 삼바노바는 기업들이 칩이나 AI 인재를 위해 싸울 필요없도록 이 데이터를 이용한 AI 모델 구축에 필요한 모든 HW와 SW를 제공할 수 있다고 말한다. 량 CEO는 “당신은 몇 달이나 몇 분기가 아니라 며칠 안에 운영할 수 있다”며 “모든 회사는 이제 자신만의 GPT 모델을 가질 수 있다”고 말했다.

반면 AI모델들이 SN40L과 같은 칩에서는 작동하기 위해서는 특별히 조정돼야 한다.

데케이트와 달리 컨설팅 회사 세미 어낼리시스의 딜런 파텔 수석분석가는 “엔비디아또한 DGX 클라우드를 통해 풀스택 AI서비스(AI-as-a-Service) 시장에 진출하고 있기에 이는 삼바노바에게 더욱 어려운 일이 될 것”이라고 말했다.

그는 “칩은 엄청난 진전이다”라면서도 “칩이 환경을 바꿀 것이라고 생각하지 않는다”고 덧붙였다. 즉, 엔비디아가 지금까지 구축해온 AI칩과 SW생태계를 넘어서기가 쉽지 않을 것임을 시사한 것이다.

과연 삼바노바의 도전은 시장에서 빛을 발할 것인가.