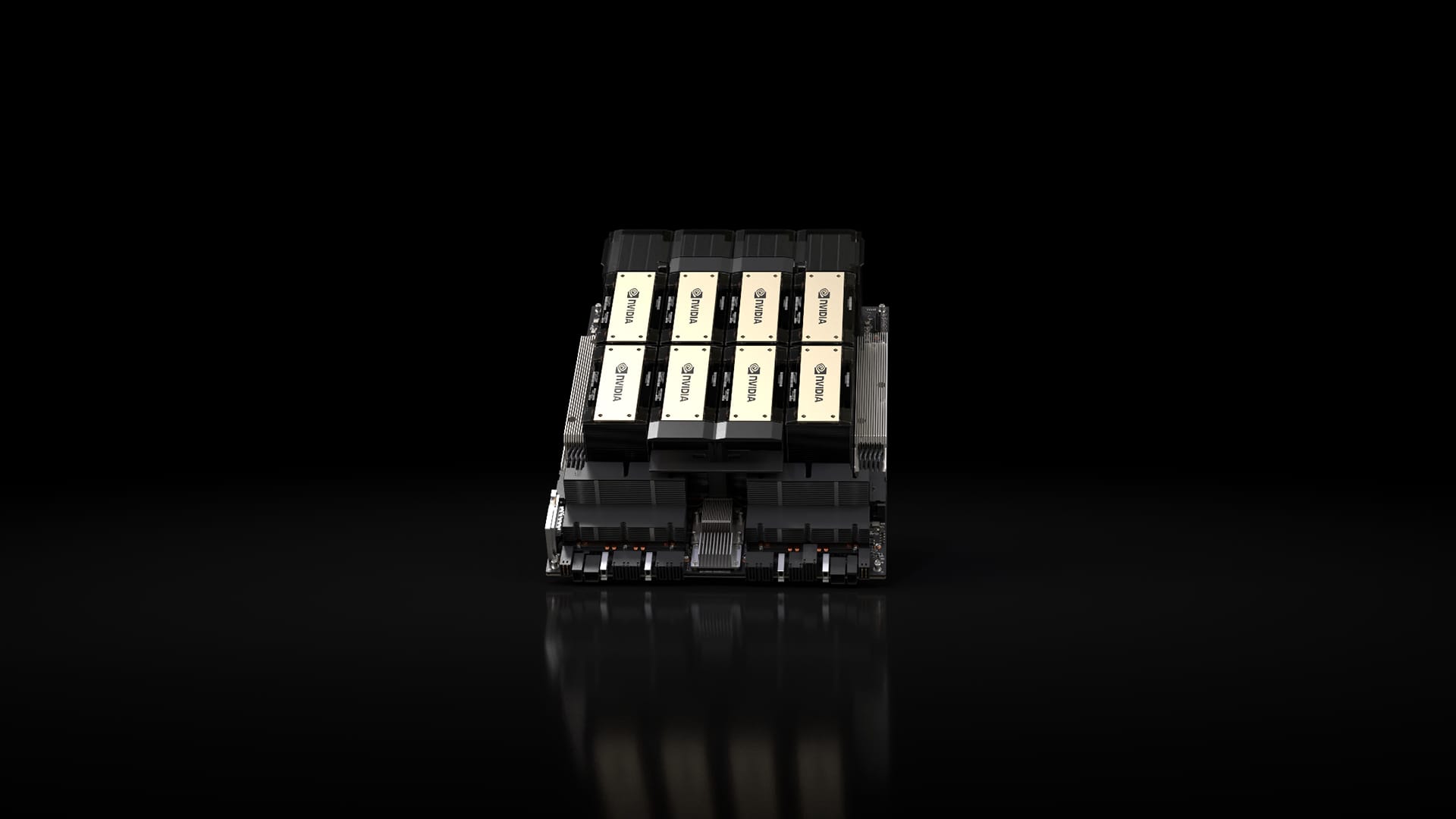

NVIDIA has unveiled the H200, a graphics processing unit (GPU) designed to train large language models (LLMs) that underpin generative AI models at twice the output speed of the original H100. The H200 is an upgraded version of the H100, which companies around the world are racing to get their hands on, including for training GPT-4, the latest LLM from ChatGPT developer OpenAI. Currently, each H100 chip is estimated to cost between $25,000 and $40,000, and thousands of chips are needed to run the LLM. The price of the H200 is not known.

엔비디아가 기존 H100의 출력 속도보다 2배 빠른 생성형 AI 모델의 기반이 되는 대규모 언어 모델(LLM)에 적용해 이를 훈련하도록 설계된 그래픽처리장치(GPU) H200을 공개했다. H200은 챗GPT 개발사 오픈AI의 최신 LLM인 GPT-4 훈련에 적용되는 등 전 세계 기업들이 확보하기 위해 경쟁을 벌이는 H100의 업그레이드 버전이다. 현재 H100 칩 1개당 가격은 2만5천달러∼4만달러로 추정되고 있으며, LLM을 구동하는 데에는 수천 개의 칩이 필요하다. 다만, H200의 가격은 알려지지 않았다.